Sự khác biệt giữa H200 và H100, đâu là GPU NVIDIA mạnh hơn?

Nội dung bài viết

Tổng quan về GPU NVIDIA H200 và H100

GPU NVIDIA H100 Tensor Core

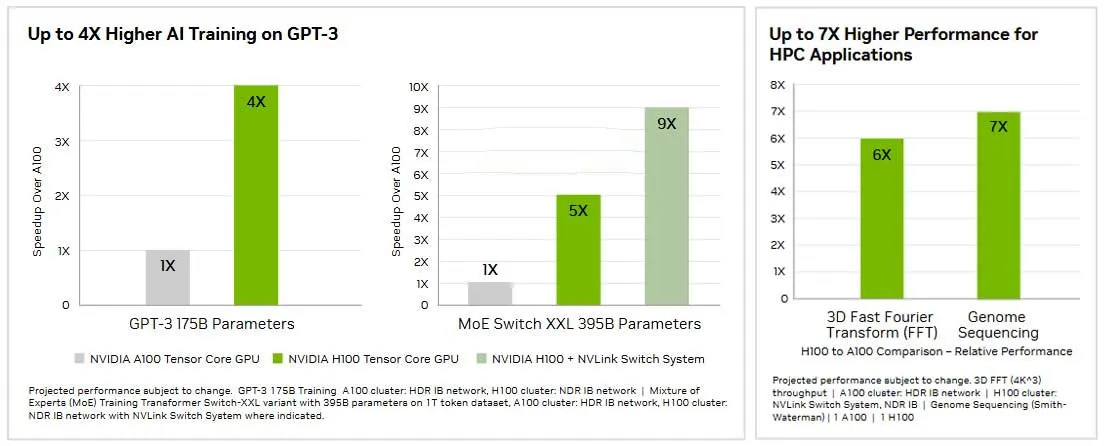

GPU NVIDIA H100 Tensor Core được xây dựng dựa trên kiến trúc NVIDIA Hopper™, giúp gia tăng đáng kể về hiệu suất, khả năng mở rộng và bảo mật cho mọi khối lượng công việc. Với Tensor Core thế hệ thứ tư và Transformer Engine hỗ trợ độ chính xác FP8, H100 cung cấp tốc độ đào tạo nhanh hơn tới 4 lần so với thế hệ trước (GPU NVIDIA A100 Tensor Core) cho các mô hình GPT-3 (175 tỷ tham số). Đặc biệt, H100 NVL dựa trên PCIe với cầu nối NVLink giúp tăng hiệu suất mô hình Llama 2 70B (70 tỷ tham số) lên đến 5 lần so với các hệ thống NVIDIA A100, đồng thời duy trì độ trễ thấp trong môi trường trung tâm dữ liệu hạn chế về nguồn điện.

Ngoài ra, H100 tăng gấp ba lần số phép tính dấu phẩy động trên giây (FLOPS) của Tensor Core độ chính xác kép, cung cấp 60 teraflop điện toán FP64, tích hợp các lệnh lập trình động (DPX) để tăng hiệu suất lên đến 7 lần cho các ứng dụng điện toán hiệu năng cao (HPC). Với GPU Multi-Instance (MIG) thế hệ thứ hai và NVIDIA Confidential Computing tích hợp và NVIDIA NVLink Switch System, H100 đảm bảo tăng tốc an toàn mọi khối lượng công việc cho mọi trung tâm dữ liệu, từ enterprise đến exascale. Kết hợp với phần mềm NVIDIA AI Enterprise trong 5 năm, H100 đơn giản hóa quá trình phát triển và triển khai AI, mang lại giá trị kinh doanh nhanh hơn và bền vững hơn.

GPU NVIDIA H200 Tensor Core

GPU NVIDIA H200 Tensor Core là phiên bản nâng cấp của H100, cũng được xây dựng dựa trên kiến trúc NVIDIA Hopper™ và kế thừa toàn bộ sức mạnh của H100. H200 xứng đáng là “người đàn anh” khi giúp đẩy nhanh hơn nữa sức mạnh tính toán cho các khối lượng công việc AI và điện toán hiệu năng cao (HPC). H200 là GPU đầu tiên được trang bị bộ nhớ HBM3e.

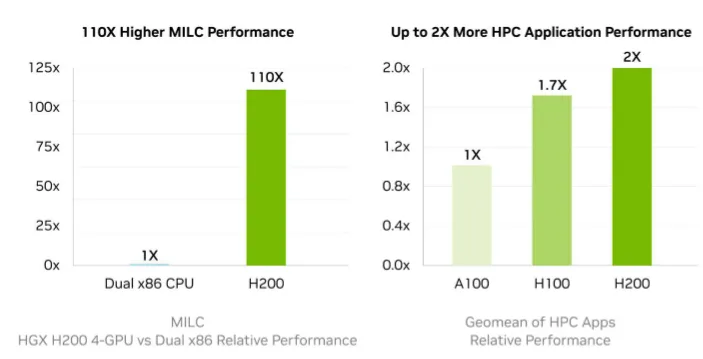

Bộ nhớ lớn hơn và băng thông cao hơn so với GPU H100 giúp H200 tăng tốc đáng kể hiệu suất suy luận trong việc đào tạo các mô hình ngôn ngữ lớn như Llama2 70B và ứng dụng AI tạo sinh. So với GPU A100, H200 cung cấp hiệu suất vượt trội hơn giúp giảm thời gian đào tạo và cải thiện hiệu quả tổng thể trong các ứng dụng AI. Ngoài ra, băng thông bộ nhớ cao của H200 đảm bảo truyền dữ liệu nhanh chóng, giảm tắc nghẽn trong xử lý các ứng dụng HPC phức tạp, mang lại thời gian đưa ra kết quả nhanh hơn so với các thế hệ GPU trước.

So sánh GPU NVIDIA H200 và H100

Các phiên bản của GPU NVIDIA H200 và H100

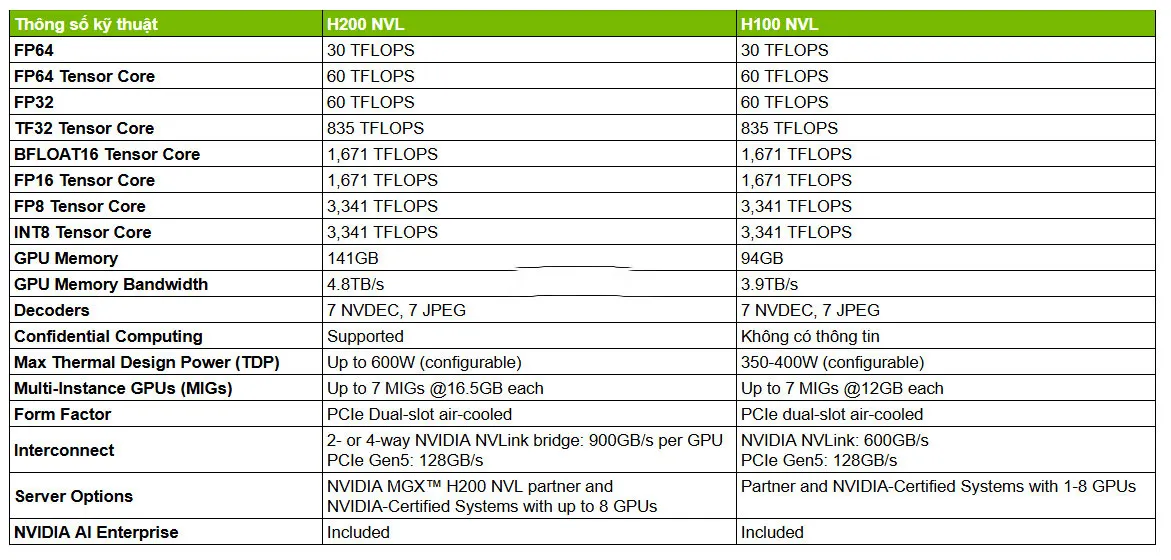

NVIDIA H200 và H100 đều được thiết kế với 2 phiên bản khác nhau chân cắm là SXM và NVL. Phiên bản SXM sử dụng chân cắm dạng socket là một thiết kế độc quyền của NVIDIA, chỉ tương thích với các dòng máy chủ của NVIDIA, cho phép kết nối truyền dữ liệu tốc độ cao, độ trễ thấp hơn so với chuẩn giao tiếp PCIe phổ biến. Trong khi đó, phiên bản NVL sử dụng các chân cắm PCIe phổ biến trong hầu hết máy chủ của các hãng khác nhau. NVIDIA thiết kế 2 phiên bản như vậy để các GPU H200 và H100 linh hoạt hơn cho từng trường hợp sử dụng cụ thể. Chúng ta sẽ so sánh thông số kỹ thuật của 2 GPU này theo từng phiên bản tương ứng.

So sánh thông số kỹ thuật H200 và H100

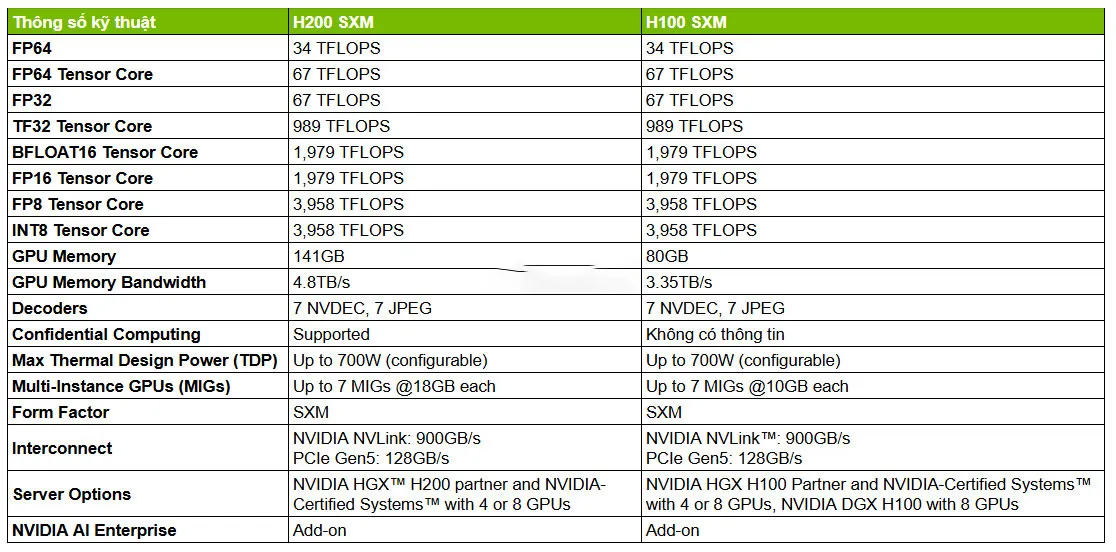

Phiên bản H200 SXM với H100 SXM

Phiên bản H200 NVL với H100 NVL

So sánh chi tiết GPU NVIDIA H200 và H100

Vì GPU NVIDIA H200 và H100 đều có 2 phiên bản khác nhau nên để thuận tiện hơn trong việc so sánh chi tiết các thông số thì trong bài viết này, Apex Globalcom sẽ so sánh chúng trên cùng phiên bản chân cắm SXM.

Bộ nhớ và băng thông

Dung lượng bộ nhớ HBM3e của GPU NVIDIA H200 là 141GB, lớn hơn gần gấp đôi so với bộ nhớ 80GB của GPU NVIDIA H100. Bộ nhớ lớn hơn cho phép H200 xử lý tốt lượng dữ liệu khổng lồ cho AI tạo sinh và các mô hình phức tạp hơn H100. Băng thông bộ nhớ GPU của H200 là 4.8TB/s, nhanh hơn khoảng 1,4 lần so với băng thông 3.35TB/s trên H100. Sự gia tăng băng thông này là cực kỳ cần thiết đối với các ứng dụng đòi hỏi khả năng truyền và xử lý dữ liệu nhanh hơn, giảm tình trạng tắc nghẽn xử lý phức tạp. Đối với các ứng dụng HPC sử dụng nhiều bộ nhớ như mô phỏng thời tiết, nghiên cứu y học và trí tuệ nhân tạo, băng thông bộ nhớ cao hơn của H200 đảm bảo dữ liệu có thể được truy cập và xử lý hiệu quả, dẫn đến thời gian đưa ra kết quả nhanh hơn khoảng 17.6% so với H100.

Điểm chuẩn hiệu suất MLPerf Inference v4.1

Điểm chuẩn hiệu suất MLPerf là một danh sách các bài kiểm tra tiêu chuẩn công nghiệp được NVIDIA thiết kế để đánh giá hiệu suất của phần cứng, phần mềm và dịch vụ suy luận AI trên nhiều nền tảng và môi trường khác nhau. Những dữ liệu này là thước đo đáng tin cậy để so sánh hiệu quả, tốc độ của các hệ thống đào tạo AI, giúp người dùng xác định công cụ và công nghệ hiệu quả nhất cho việc triển khai AI tạo sinh và Mô hình ngôn ngữ lớn (LLM).

Trong kịch bản ngoại tuyến, chạy với mô hình Llama2 70B, GPU NVIDIA H100 đạt được thông lượng là 24,525 tokens/giây trong khi GPU NVIDIA H200 là 34,864 tokens/giây. Hiệu suất của H200 nâng cao hơn khoảng 42.16% so với H100.

Trong kịch bản máy chủ, cũng với mô hình Llama2 70B, H100 có thông lượng 23,700 tokens/giây trong khi H200 là 32,790 tokens/giây (cải thiện hơn khoảng 38.35% so với H100).

Khả năng tăng tốc suy luận AI

Khi AI không ngừng phát triển, các doanh nghiệp cần dựa vào mô hình ngôn ngữ lớn để giải quyết nhiều nhu cầu suy luận khác nhau. Một trình tăng tốc suy luận AI phải cung cấp thông lượng cao nhất với TCO thấp nhất khi triển khai ở quy mô lớn cho lượng người dùng lớn. Theo thống kê, H200 tăng gấp đôi hiệu suất suy luận so với GPU H100 khi xử lý các mô hình ngôn ngữ lớn như Llama2 70B, với Chat GPT-3 175B thì gấp 1.6 lần.

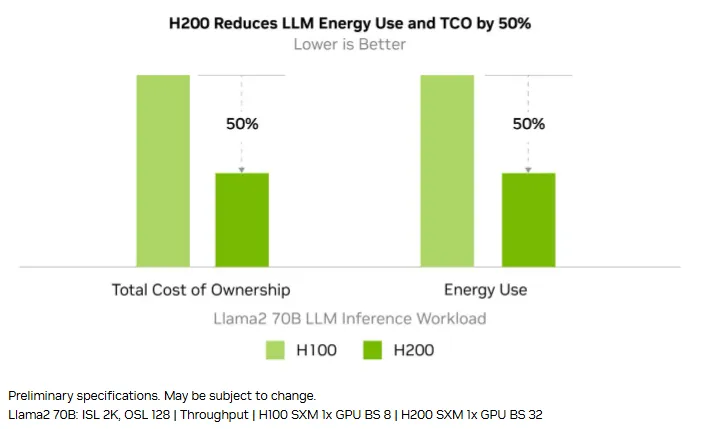

Hiệu quả tiết kiệm năng lượng

Với sự ra đời của H200, hiệu quả tiết kiệm năng lượng và TCO được cải thiện 50% so với H100. Các nhà máy AI và hệ thống siêu máy tính không chỉ nhanh hơn mà còn thân thiện với môi trường hơn mang lại lợi thế kinh tế, thúc đẩy cộng đồng AI và khoa học tiến lên phía trước.

GPU NVIDIA H200 hay H100 mạnh hơn?

Dựa vào các nội dung so sánh ở trên, chúng ta thấy rõ ràng NVIDIA H200 mạnh hơn NVIDIA H100 về bộ nhớ GPU, băng thông bộ nhớ GPU nhưng lại tiết kiệm năng lượng hơn 50% trong các tác vụ suy luận mô hình ngôn ngữ lớn. Điều này cho phép H200 mang lại hiệu suất cao hơn H100 đặc biệt là trong các ứng dụng LLM và HPC yêu cầu xử lý tập dữ liệu lớn và phức tạp.

Tóm lại, nếu doanh nghiệp có đủ ngân sách và muốn một GPU cực mạnh để xử lý các tác vụ suy luận AI trong mô hình ngôn ngữ lớn, AI tạo sinh, HPC hiệu năng siêu cao thì có thể mua GPU NVIDIA H200, còn với ngân sách khiêm tốn hơn, H100 vẫn là một lựa chọn đáng giá, đủ mạnh mẽ cho hầu hết các tác vụ AI.

Thiết bị chuyển mạch Switch

Thiết bị chuyển mạch Switch

Thiết bị tường lửa Firewall

Thiết bị tường lửa Firewall

Thiết bị định tuyến Router

Thiết bị định tuyến Router

Thiết bị lưu trữ (SAN, NAS)

Thiết bị lưu trữ (SAN, NAS)

Module Quang

Module Quang

Máy chủ (Server)

Máy chủ (Server)

Load Balancing

Load Balancing